UNIVERSIDADE FEDERAL DE SANTA CATARINA

PROGRAMA DE PÓS-GRADUAÇÃO EM CIÊNCIA DA COMPUTAÇÃO

Ademir Goulart

AVALIAÇÃO DE MECANISMOS DE COMUNICAÇÃO EM GRUPO PARA

AMBIENTE WAN

Dissertação submetida à Universidade federal de Santa

Catarina como parte dos requisitos para a obtenção do grau de Mestre em Ciência

da Computação

Luis Fernando

Friedrich, Dr

Florianópolis, junho de

2002

AVALIAÇÃO DE MECANISMOS DE COMUNICAÇÃO EM GRUPO PARA

AMBIENTE WAN

Ademir Goulart

Esta dissertação foi julgada adequada para a obtenção

do título de Mestre em Ciência da Computação, Área de Concentração Sistemas de

Computação e aprovada em sua forma final pelo Programa de Pós-Graduação em

Ciência da Computação.

__________________________________

Prof. Luis Fernando Friedrich, Dr

__________________________________

Prof. Fernando Álvaro Ostuni

Gauthier, Dr

Banca Examinadora

__________________________________

Prof.

Luis Fernando Friedrich, Dr.

__________________________________

Profa.

Anita Maria da Rocha Fernandes, Dra

__________________________________

Prof.

Rômulo Silva de Oliveira, Dr.

__________________________________

Prof.

Vitório Bruno Mazzola, Dr.

Aos meus filhos Gabriel e Miguel

... aprendi que o mais valioso não é o que temos em nossas vidas,

mas sim quem temos em nossas vidas

AGRADECIMENTOS

A Universidade do Vale do

Itajaí, por proporcionar o apoio

necessário e o acesso aos laboratórios para a construção deste trabalho.

Ao meu orientador, Luis

Fernando Friedrich, Dr., pelo seu empenho a fim de enriquecer o trabalho e sua

pronta disposição para o atendimento

deste orientando.

Ao Alex Kuhnen pelo auxilio

na codificação dos programas de

demonstração no ambiente WINDOWS em Visual C, especialmente no tratamento da

interface gráfica.

Ao Daniel Amaral Manfredine

da UNIVALI, Oficina do Design, Campus de Balneário Camboriu, pela sua ajuda no desenvolvimento e edição

das figuras.

Ao amigo Neto, José Morelli

Neto, pela ajuda prestada no Campus de Balneário Camboriu, seja configurando

máquinas nos laboratórios para a execução dos testes ou emprestando o seu

“LINUX particular” para hospedar um daemon SPREAD.

Aos colegas professores do

Curso de Ciências da Computação da UNIVALI pelo incentivo.

A todos os demais, não

nomeados, que de forma direta ou indireta contribuíram para a realização deste

trabalho.

RESUMO

Este trabalho é um estudo sobre comunicação em grupo usada em

sistemas distribuídos. É feita uma avaliação de diversos mecanismos de

Comunicação em grupo existentes atualmente. Para uma análise mais detalhada,

são selecionados três ambientes que trabalham tanto em redes locais como em

redes de longa distância. Finalmente um dos mecanismos de comunicação em grupo

é escolhido, o SPREAD, e submetido a testes de volume, funcionalidades e

performance em um ambiente real de rede WAN. Também uma aplicação de

gerenciamento de recursos em ambiente de sistemas distribuídos foi desenvolvida

para ilustrar o uso deste mecanismo de comunicação em grupo. Concluí-se que o

SPREAD tem boa performance e escalabilidade em ambiente WAN podendo ser usado

plenamente em uma ferramenta de gerência de recursos em sistemas distribuídos.

Palavras

chaves: Comunicação em grupo, gerência de recursos, sistemas distribuídos

ABSTRACT

This paper is a study about group

communication used in distributed system. An evaluation of several mechanisms

is made about group communication available at the moment. Three environments

that work as in local area as wide area network are selected for a more

detailed analysis. Finally, one mechanism of group communication is chosen, the

SPREAD software, and it is evaluated concerning scalability, performance and

functionality using a real environment of wide area network. An application of

resource management for distributed systems was also developed to demonstrate

the facilities of this group communication software. It was conclude that SPREAD have a good performance and

scalability in WAN and can be used for developing resource management software

in distributed systems.

Key words: Group Communication, resource management,

distributed systems

Redes de computadores

estão por toda parte. A Interne é uma, como são as muitas redes que a compõem.

Redes de telefonia celular, redes corporativas, redes fabris, redes em campus,

redes domésticas, redes embarcadas, todas estas sejam redes locais LAN (Local

Area Network) ou redes de longa distância WAN (Wide Area Network),

tanto separadamente como em conjunto, compartilham as características

essenciais que fazem delas um modelo relevante para o estudo sob o título

Sistemas Distribuídos.

Uma definição de sistemas

distribuídos é aquela na qual os componentes de hardware e software localizados

em computadores interligados por rede, comunicam e coordenam suas ações somente

através da troca de mensagens (COULOURIS, 2001).

A comunicação entre os

computadores interligados, pode ocorrer de diferentes formas, usando diversos

protocolos tanto em ambiente de rede local como ambiente de redes de longa

distância. Um caso particular de comunicação ocorre quando uma mesma mensagem

tem que ser enviada para diversos computadores na rede. Alguns ambientes

físicos de rede permitem o broadcast, onde um único comando de envio manda

a mensagem para todos os endereços da rede, porém a confiabilidade deste método

não é garantida, podendo ocorrer alguma perda sem que o emissor da mensagem

seja notificado da mesma.

Com o intuito de atender

a necessidade de comunicação de um para muitos, com confiabilidade,

escalabilidade, e de forma transparente para quem desenvolve a aplicação, foi

criado um novo paradigma chamado Comunicação em Grupo. Um protocolo de

Comunicação em Grupo separa a complexidade de controle e gerenciamento das

mensagens, da complexidade da aplicação, tratando os diversos computadores como

sendo pertencentes a um grupo. Assim, o projetista se preocupa apenas com a

aplicação, suas funcionalidades, seus procedimentos, seus algoritmos

particulares, sem envolver-se com os problemas da comunicação. Passa a ser

responsabilidade do Protocolo de Comunicação em Grupo a controle de fluxo, a

confiabilidade, o sequenciamento e a garantia de entrega das mensagens ao

aplicativo final, bem como, o controle de quais computadores estão fazendo

parte deste grupo, gerenciando a entrada de novos membros no grupo, saída

voluntária ou saída involuntária devido à quebra no computador ou

particionamento da rede. Um

particionamento da rede acontece quando existe uma separação de dois

segmentos de redes que perdem a comunicação entre si.

Ao considerar a

importância dos mecanismos de Comunicação em Grupo existentes, este trabalho

visa realizar uma avaliação nas diferentes alternativas disponíveis e em

especial naquelas que tratam ambientes de redes de longa distância (WAN), onde

o particionamento, a latência e o assincronismo tornam este paradigma bem mais

complexo.

Para ilustrar de forma

prática o uso de um mecanismo de Comunicação em Grupo, será implementada uma

aplicação que visa o gerenciamento de recursos em sistemas distribuídos.

Este trabalho tem como

objetivo geral fazer uma avaliação dos mecanismos de Comunicação em Grupo para

ambiente WAN e como objetivos

específicos pode-se citar:

·

Estudar sistemas distribuídos e paralelos.

·

Estudar as características de hardware que atendem

sistemas distribuídos.

·

Estudar as características dos softwares que atendem

sistemas distribuídos.

·

Estudar os midleware (camadas de software entre

os aplicativos e o sistema operacional) de sistemas distribuídos, CORBA, JAVA

RMI, DCOM, DCE.

·

Estudar detalhadamente Comunicação em Grupo.

·

Avaliar conceitualmente os principais mecanismos de

Comunicação em Grupo.

·

Selecionar três mecanismos para um estudo mais

detalhado.

·

Selecionar um dos três para usar em uma implementação

prática.

·

Desenvolver uma aplicação para gerenciamento de recursos em um ambiente de sistemas

distribuídos.

·

Fazer uma avaliação de performance, do mecanismo

selecionado, considerando volume, escalabilidade e funcionalidades.

O uso de mecanismos de

comunicação em grupo, torna a aplicação muito simples de ser codificada, pois

toda a complexidade da comunicação, seus controles, sua segurança, seu fluxo,

passam a ser tratados de forma transparente para quem faz a aplicação. Também o fator escalabilidade é muito

importante, pois o aplicativo que roda para um computador, poderá rodar para N

computadores, sem nenhuma alteração.

No passado, quando

tinha-se apenas sistemas centralizados com o uso de terminais, o gerenciamento

dos recursos eram simples pois, todos os recursos a serem mensurados estavam

centralizados em um único local.

Com o ambiente de redes,

onde tem-se eventualmente que

administrar milhares de microcomputadores, a gerência destes recursos se

torna um problema complexo devido a localização e grande quantidade de máquinas

a serem consideradas no gerenciamento.

Assim, a idéia é

aproveitar todas as facilidades que um mecanismo de comunicação em grupo

oferece, e desenvolver uma aplicação cliente que estara rodando em todas as

máquinas, fazendo parte de um grupo geral, o qual fornece informações de

gerenciamento a um ponto central de

gerenciamento da rede, caracterizando assim uma aplicação de gerência de

recursos em sistemas distribuídos.

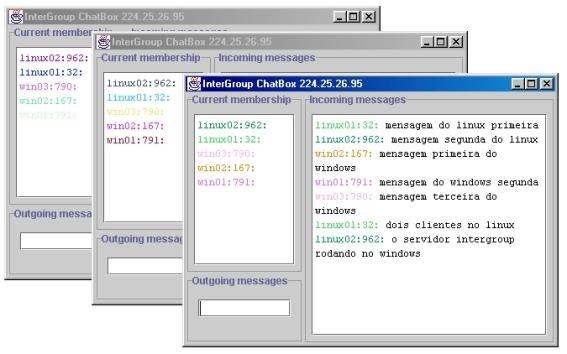

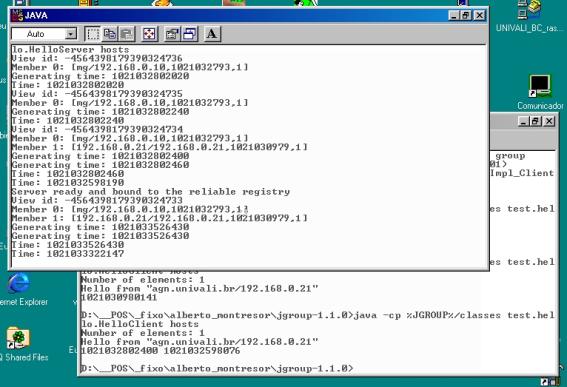

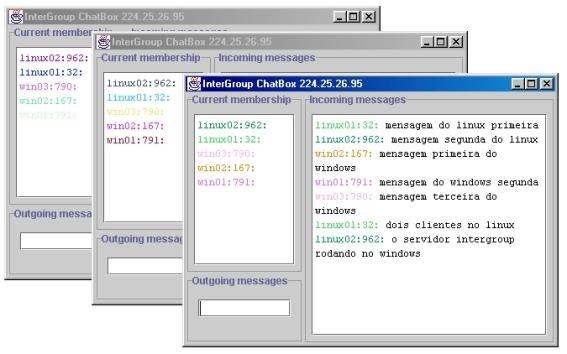

O mecanismo de

comunicação em grupo selecionado para ser usado na implementação de uma

aplicação prática foi o SPREAD. Assim, configura-se a rede para que em cada

segmento da mesma tenha-se um daemon, uma cópia do SPREAD executando e

todos os clientes locais deste segmento, sendo controlados por esta cópia

local. Como se tem acesso ao fonte do

SPREAD, e já estando portado para múltiplas plataformas como diversos UNIX, MAC

e WINDOWS, efetua-se a compilação em LINUX. Optou-se por rodar o SPREAD em um

servidor usando LINUX, o mesmo que hoje já é usado para os serviços de WEB e

E-mail nestes segmentos de redes.

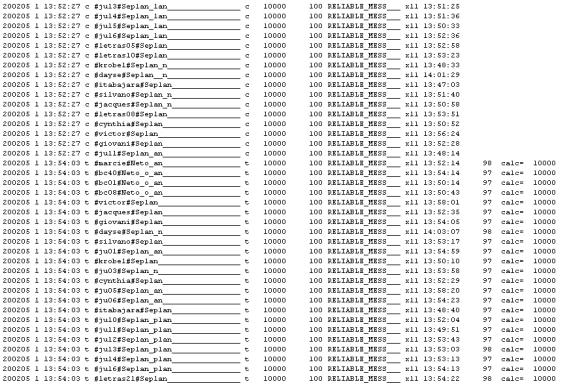

Para os aplicativos foram

usados ambientes WINDOWS com compilador Visual C e LINUX com compilador GCC. As

aplicações em ambiente gráfico, clientes que rodam em máquinas WINDOWS, e

programa de consulta com interface gráfica, foram desenvolvidos em C e

compilados com Visual C da Microsoft. Já o programa que coleta as informações

da hora que a máquina foi ligada ou desligada, gravando um log (arquivo

com registros de controle gravados em ordem cronológica) em disco, foi

desenvolvido em C, compilado com GCC no LINUX e roda no mesmo servidor que

executa o SPREAD.

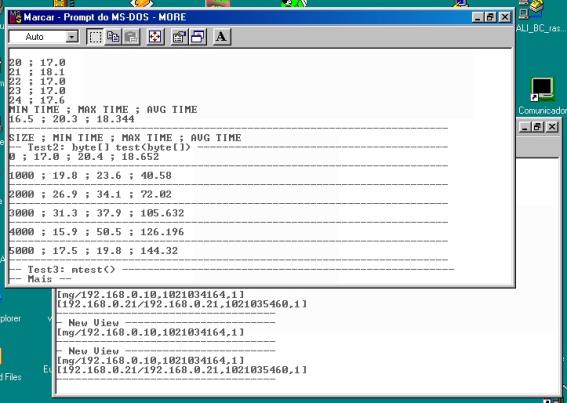

Para os aplicativos que

medem performance, avaliando o tempo no recebimento de diferentes conjuntos de

mensagens, foram empregados compiladores Visual C e GCC sendo que todos os

programas rodam tanto em WINDOWS como em LINUX.

Como ambiente de redes,

usou-se a topologia da UNIVALI, com redes locais, servidores locais em cada um

dos Campi, usando fast ethernet e gigabit ethernet sendo os

pontos de rede geralmente ligados a switch. Os segmentos locais estão

interligados ao Campus principal de Itajaí por links WAN de 2 Megabits.

O presente documento

contém inicialmente o capítulo 2 onde é apresentada a conceituação básica para

sistemas distribuídos. Além das características relativas ao hardware e os

softwares básicos que atendem o conceito de sistemas distribuídos, também o

paradigma de orientação a objeto é abordado. Assim como, o uso de CORBA, JAVA

RMI, DCOM e DCE são considerados nesta parte de conceituação básica.

O capítulo 3, é

inteiramente dedicado para detalhar conceitualmente o que é Comunicação em

Grupo, com suas características, funcionalidades, requisitos e padrões adotados.

No capítulo 4,

tem-se uma visão geral de diversos

mecanismos de Comunicação em Grupo, com suas características principais. Como foram selecionados três ambientes para

um estudo mais detalhado, cada um deles passa a ser detalhado em um capítulo

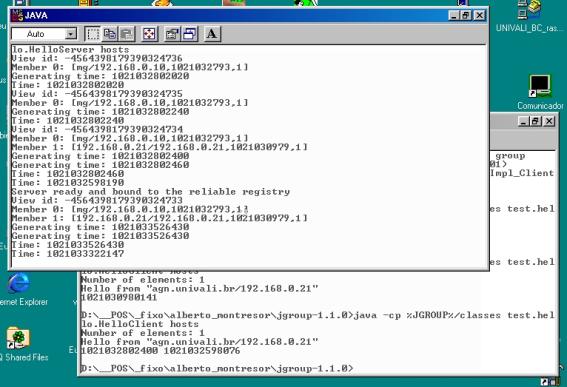

específico, sendo no capítulo 5 o INTERGROUP, no capítulo 6 o JGROUP e no

capítulo 7 o SPREAD.

A descrição da aplicação

de gerência de recursos em ambiente distribuído, bem como os resultados da

avaliação de desempenho estão detalhados no capítulo 8.

Para finalizar tem-se a

conclusão no capítulo 9 e na seqüência os anexos com os programas fontes que

foram desenvolvidos para avaliação de desempenho usando o SPREAD.

Neste capitulo, apresenta-se uma série de conceitos que são importantes

para o perfeito entendimento e enquadramento do assunto objeto, Comunicação em

Grupo. Inicia-se com uma caracterização dos sistemas distribuídos e paralelos,

bem como, apresentando motivações para o uso de sistemas distribuídos. Na

seqüência é abordado o aspecto de hardware, apresentando arquiteturas

atualmente em uso para sistemas distribuídos. Os aspectos de software como

sistemas operacionais, linguagens de programação e ambientes distribuídos

também são explorados neste capítulo.

Para encerrar a conceituação básica, apresentam-se as arquiteturas

adotadas na comunicação de sistemas distribuídos.

Os primeiros computadores produzidos para uso comercial, na década de 70,

tinham uma estrutura padrão baseada em processador, memória e armazenamento de

dados. Devido ao alto custo dos componentes, na época, as capacidades de

memória e de discos destes precursores dos equipamentos hoje conhecidos como mainframe, eram mínimas se comparado com equipamentos atuais.

Para exemplificar um modelo de

equipamento IBM 360/30, tinha memória de 32Kb, 3 discos de 10 MB, leitora

perfuradora de cartões, leitora de fita de papel, e 6 unidades de fitas

magnéticas. Na evolução tem-se os minicomputadores, os microcomputadores, o

computador pessoal ou PC e a interligação dos equipamentos em rede.

A interligação das máquinas em redes propiciou o surgimento do conceito

de sistemas distribuídos, aproveitando o potencial das máquinas interligadas.

De outro lado, tem-se os sistemas compostos de um único processador, memória e

periféricos os quais são chamados de sistemas centralizados. Segundo Tanenbaum

(1995), no passado era válido a Lei de Grosch, um especialista em computação,

preconizando que “o poder computacional de um processador é proporcional ao

quadrado de seu preço, ou seja, pagando duas vezes mais, pode-se obter o

quádruplo da performance”. Hoje em dia esta Lei de Grosch não é mais válida,

pois com as novas tecnologias, em especial usando arquitetura INTEL a cada ano,

pelo mesmo preço, obtemos o dobro ou o quádruplo de performance em relação ao

equipamento anterior.

Quando se avalia o custo de micros pessoais PC, encontra-se ótima relação

preço/performance. Quando se coloca uma máquina, independente para cada

usuário, tem-se a dificuldade de compartilhar os dados. Além da comunicação

necessária entre os usuários, é desejável o compartilhamento de recursos tais

como impressoras, gravador de CD, etc. Este compartilhamento é possível se as

máquinas estiverem interligadas em rede. Assim um sistema distribuído pode ser

implementado com computadores pessoais ligados em rede a servidores, os quais

executariam os processos mais pesados

de forma distribuída.

Apesar de todas as vantagens dos sistemas

distribuídos, encontram-se algumas dificuldades neste ambiente. O software para

sistemas distribuídos é mais complexo. Desta forma sistemas operacionais,

linguagens e mesmo aplicativos para este ambiente são relativamente novos, em

fase de pesquisa, e não estão plenamente consolidados. Também a rede para

interligar, seja rede local (LAN- Local Area Network) ou rede de longa

distância (WAN- Wide Area Network), não tem a confiabilidade total para

a interligação, podendo ocorrer perda por interrupção do link (caminho

que interliga fisicamente dois pontos de rede) ou saturação devido à sobrecarga

na banda disponível. Cabe então as soluções de software, tratar estas

interrupções com protocolos e rotinas adequadas a este contexto. Um resumo das

características de sistemas distribuídos, é mostrado no Quadro 1 segundo Tanenbaum (1995).

As estratégias adotadas para a implementação

de sistemas distribuídos dependem de diversos fatores. Tem-se que levar em

conta o objetivo da aplicação, as características e restrições do ambiente, o

custo do projeto, etc. As estratégias mais importantes, segundo Veríssimo

(2001), são: distribuição para informação e compartilhamento de recursos;

distribuição para maior disponibilidade e performance; distribuição para

modularidade; distribuição para a descentralização e distribuição para

segurança.

Quadro

1

Características de Sistemas Distribuídos

|

ITEM

|

DESCRIÇÃO

|

|

Relação Custo Benefício

|

Os microprocessadores oferecem uma melhor

relação preço/performance do que a oferecida pelos mainframes.

|

|

Desempenho

|

Um sistema distribuído pode ter um poder

de processamento maior que o de qualquer mainframe.

|

|

Confiabilidade

|

Se uma máquina sair do ar, o sistema como

um todo pode sobreviver

|

|

Crescimento Incremental

|

O poder computacional pode crescer em

doses homeopáticas

|

|

Compartilhamento

|

Permite que mais de um usuário acesse uma

base de dados comum, ou periféricos muito caros.

|

|

Comunicação

|

Torna muito mais simples a comunicação

pessoa a pessoa, por exemplo, empregando o correio eletrônico.

|

|

Flexibilidade

|

Espalha a carga de trabalho por todas as

máquinas disponíveis ao longo da rede.

|

|

Restrições

|

Até o presente momento não há muita

disponibilidade de software para os sistemas distribuídos. Pode-se ter

problemas de muito tráfego na rede ou problemas com segurança dos dados.

|

As estratégias adotadas para a implementação

de sistemas distribuídos dependem de diversos fatores. Tem-se que levar em

conta o objetivo da aplicação, as características e restrições do ambiente, o

custo do projeto, etc. As estratégias mais importantes, segundo Veríssimo

(2001), são: distribuição para informação e compartilhamento de recursos;

distribuição para maior disponibilidade e performance; distribuição para

modularidade; distribuição para a descentralização e distribuição para

segurança.

Alguns compromissos precisam ser atendidos,

dependendo das particularidades das aplicações:

·

Controle centralizado versus descentralizado –

Controle centralizado é mais fácil de implementar e gerenciar. Contudo, alguns

problemas de descentralização e natureza distribuída, são melhores resolvidos

com aplicações descentralizadas. Também podem ser consideradas arquiteturas

intermediárias com transparência distribuída, mas de controle centralizado.

·

Distribuição seqüencial versus concorrente

- O uso do processamento concorrente,

onde tem-se diversos procedimentos executando ao mesmo tempo devido a

requisições simultâneas, comparativamente ao processamento seqüencial no caso

de chamadas que podem ser atendidas uma a uma.

·

Distribuição visível versus invisível – Pode-se

dizer que a distribuição é invisível ou transparente quando se usam modelos que

escondem a distribuição. Assim em modelos usando RPC (Remote Procedure Call),

CORBA (Common Object Request Broker Architecture) ou DCOM (Distributed

Component Object Model) a distribuição se torna transparente. Distribuição

visível é quando a aplicação se vale de mecanismos de passagem de mensagens,

tais como orientados a grupos e modelos usando

barramento de mensagens.

·

Envio de dados versus código – O que é

distribuído, dados ou código? Normalmente distribuem-se dados para serem

processados em equipamentos diferentes, porém, é possível também, enviar código

para processar as instruções localmente, como no caso de applets.

·

Servidor versus serviço – Deve-se considerar que

um serviço pode estar em mais do que um servidor e que em um servidor pode-se

estar executando diversos serviços.

·

Escala versus performance – A escalabilidade

normalmente é inversamente proporcional à performance. Uma boa arquitetura que

permita escalabilidade, ou seja, possa crescer em número de componentes, não

deve ter a sua performance linearmente diminuída, devido a este

crescimento.

·

Sincronismo versus assincronismo – Assíncronos

são sistemas mais simples, mas independentes de tempo, enquanto síncronos são

sistemas mais complexos e tem a habilidade de assegurar especificações de

controle de tempo.

Muitos destes compromissos podem ser

avaliados em conjunto e assim pode-se classificar a distribuição como segue:

·

Distribuição em baixa escala – Em ambientes mais

homogêneos usando LANs ou redes de alta velocidade, onde um comportamento

controlado pode ser obtido para aplicações que requerem segurança e sincronismo

·

Distribuição em larga escala – Em ambientes de

sistema distribuídos, em ambientes abertos, tipicamente de natureza

heterogênea, sobre WANs interconectando LANs onde o comportamento é incerto e

aplicações podem existir de forma não síncrona.

Esta é a forma como nasceram sistemas

distribuídos e ainda é o objetivo estratégico da maior parte dos sistemas

distribuídos. A tecnologia que diz respeito a esta estratégia de implementação,

está relacionada com servidores centrais, protocolos de sessão remota,

computação cliente-servidor, HTTP, cliente leve e computação em rede. Também

está relacionada com as clássicas formas de disseminação da informação como

NEWS, BBS e e-mail. Os esforços estão concentrados no lado do usuário,

para garantir o acesso às informações e recursos que residem em servidores

centrais. São importantes neste contexto o gerenciamento de usuários, segurança

no estabelecimento da sessão, largura de banda e confiabilidade e software no

lado cliente.

Na estratégia de distribuir para maior

disponibilidade e performance, o que se tem é a vantagem de diversos servidores

contra um único servidor central ou mesmo mainframe. Se se tem um único

ponto de falha com servidor central, com múltiplos servidores tem-se uma

disponibilidade muito maior, pois em caso de queda de um dos servidores, ainda

tem se a disponibilidade de atendimento por outros servidores. Quanto à

performance, um único equipamento tem um limite na sua performance, enquanto

que com diversos servidores tem se a possibilidade de balancear o acesso aos

servidores, o que nos dará uma performance muito superior a de um único

servidor central.

Mesmo para uma empresa que tenha todas as

facilidades de computação centralizadas, onde todos os usuários estão no mesmo

ambiente, ainda assim, a modularidade é relevante como uma das

estratégias. Mesmo com um custo

superior se comparado a um único sistema integrado, na modularidade podemos ter

benefícios no gerenciamento das incertezas quanto ao crescimento da organização

e sua atividade (geografia, escala, reengenharia, reorientação, mercados, etc).

Em atendendo a modularidade, adicionalmente têm-se as vantagens discutidas

anteriormente de disponibilidade e performance.

Diversas atividades conduzidas por pessoas

nas organizações, são descentralizadas pela natureza da própria atividade.

Antes dos sistemas distribuídos, ou se

tinha esta facilidade de computação em um computador central, ligando terminais

remotos aos locais do usuário ou se tinha ilhas de processamento com

computadores isolados atendendo estas aplicações descentralizadas. Com a estratégia de distribuir para a

descentralização, passa-se a ter integração e ao mesmo tempo a disponibilidade

em áreas descentralizadas das empresas. Esta estratégia permite descentralizar

o controle, colocando ele onde for necessário, enquanto mantém o grau de

integração e coordenação entre os diferentes pontos distribuídos.

A segurança pode ser aumentada quando se tem

distribuição. Em áreas de proteção e criptografia baseadas em servidores de

votação, tem se mais robustez se comparado a sistemas de um único servidor.

Sistemas de arquivamento baseados em fragmentação e espalhamento em diversos

servidores de arquivos, aumentam a segurança se comparado a servidor único que

contém o arquivo inteiro.

Segundo Buyya (1999), “a principal razão para a criação e o uso de

computadores paralelos é que o paralelismo é uma das melhores formas de

resolver o problema de gargalo de processamento em sistemas de um único

processador”. A relação preço

performance de um pequeno sistema de processamento paralelo em cluster é muito

melhor se comparado com um minicomputador.

Quadro

2 Características Principais dos Computadores

Paralelos

|

Características

|

MPP

|

SMP CC-NUMA

|

Cluster

|

Distribuição

|

|

Número de Nós

|

0(100)- (1000)

|

0(10)-0(100)

|

0(100)ou menos

|

0(10)-0(1000)

|

|

Complexidade

do Nó

|

Granularidade

fina ou média

|

Granularidade

Média ou grossa

|

Granularidade

média

|

Alcançe largo

|

|

Comunicação

inter Nos

|

Troca

mensagens / variáveis compartilhadas

|

Centralizada

e Memória compartilhada distribuída

|

Troca

de mensagens

|

Arquivos compartilhados, RPC , IPC e troca

mensagens

|

|

Controle

de jobs

|

Fila

única no host

|

Fila

única geralmente

|

Múltiplas

filas mas coordenadas

|

Filas

independentes

|

|

Suporte

a SSI Imagem de Sistema Único

|

Parcialmente

|

Sempre

no SMP e alguns NUMA

|

Desejável

|

Não

|

|

Copias

de SO e tipo

|

N

micro-kernel monolítico ou SO em camadas

|

Um

monolítico SMP e muitos para NUMA

|

N

SO plataforma homogênea ou micro-kernel

|

N

SO plataforma homogêneas

|

|

Espaço

endereçamento

|

Múltiplo

– Simples para DSM

|

Simples

|

Múltiplo

ou Simples

|

Múltiplo

|

|

Segurança

entre os nós

|

Não

necessário

|

Não

Necessário

|

Requer

se exposto

|

Requer

|

|

Onde

se aplica

|

Uma

Empresa

|

Uma

Empresa

|

Uma

ou mais empresas

|

Muitas

empresas

|

O desenvolvimento e a produção de

sistemas de moderada velocidade usando arquitetura paralela é muito mais barato

do que o seu equivalente em performance para sistemas de um único processador.

A taxonomia das arquiteturas de computadores paralelos, de acordo com seus

processadores, memória e forma de interconexão pode ser (BUYYA, 1999):

·

MPP (Massively Parallel Processors)

Processadores Paralelos

·

SMP (Symmetric Multiprocessors) Multiprocessadores

simétricos

·

CC-NUMA (Cache-Coherente Nonuniform Memory Access)

Processador com memória cache e que também acessa as memórias dos outros

processadores

·

Sistemas Distribuídos

·

Cluster

O Quadro 2 mostra uma comparação das características funcionais

e arquitetura destas máquinas.

A classificação de Buyya (1999), segue a classificação de Tanenbaum

(1995), que é mais geral e que refina a classificação apresentada por Flynn

apud Tanenbaum (1995), para arquitetura de computadores. A taxonomia de Flynn

leva em consideração fluxo de instrução e fluxo de dados, como segue:

·

SISD – Single Instruction Stream, Single Data Stream

– Um único fluxo de instruções e um único fluxo de dados.

·

SIMD – Single Instruction Stream, Multiple Data

Stream – Um único fluxo de instruções e múltiplo fluxo de dados.

·

MIMD – Multiple Instruction Stream, Multiple Data

Stream – Múltiplo fluxo de instruções e múltiplo fluxo de dados.

Para Tanebaum (1995), as máquinas com múltiplo fluxo de instruções e

múltiplo fluxo de dados ainda se dividem nos chamados multiprocessadores,

para os que têm memória compartilhada e multicomputadores para os que

não tem memória compartilhada. Tanto os multiprocessadores como os

multicomputadores podem ser divididos em duas categorias, tomando por base a

arquitetura de rede de interconexão, sendo uma do tipo baseada em barramento e

outra comutada respectivamente. Os

multiprocessadores cuja conexão é feita com barramento, ou seja um backplane

de alta velocidade, são também chamados de fortemente acoplados e os

multicomputadores interligados via rede ou outros dispositivos comutados em

baixa velocidade, são também chamados de fracamente acoplados. A Figura 1 (TANENBAUM, 1995), mostra esta classificação para os

sistemas distribuídos e paralelos.

Figura

1 Uma

Taxonomia para Sistemas Distribuídos e Sistemas Paralelos

A característica básica dos multiprocessadores é que a comunicação entre

os processadores se dá através de memória compartilhada. Uma área única de

memória sendo acessada simultaneamente por diversos processadores pode causar

um gargalo. Assim, o conceito de memória de alta velocidade de acesso também

conhecido como memória cache, passa a ser adotado, tendo cada

processador a sua memória cache própria. Para manter todos os cache

atualizados uma técnica chamada write-trhough onde toda a gravação é

feita na memória principal e a leitura na memória cache. Também todas as cache ficam

monitorando o barramento e se uma alteração ocorre na memória principal cujo

endereço também está na cache de um processador este atualiza o conteúdo

da cache. A Figura 2 (TANENBAUM,

1995), ilustra um sistema distribuído baseado em barramento.

Figura

2 Sistema Distribuído Baseado em Barramento

Os sistemas multiprocessadores podem também ser ligado por comutação.

Assim divide-se a memória em blocos e o acesso dos processadores aos blocos de

memória pode ser feito através de comutação crossbar como mostra a Figura 3 (TANENBAUM, 1995). Em cada intersecção existe uma

chave eletrônica que pode ser aberta ou fechada por hardware.

Figura

3

Comutação Crossbar

Alternativa é usar uma solução denominada rede Omega, onde cada chave tem

duas entrada e duas saídas reduzindo o número de comutações de n² para nlog2n.

A Figura 4 (TANENBAUM, 1995), mostra esta alternativa para n

igual a 4.

Figura

4

Rede Omega

Esta alternativa exige chaves de comutação muito rápidas e se tivermos um

número de processadores muito grande as chaves de comutação se tornam um

gargalo.

Os sistemas multicomputadores, onde não se tem memória compartilhada

entre os processadores, não apresentam as dificuldades citadas anteriormente.

Para os sistemas multicomputadores ligados em barramento a interconexão pode

ser feita via rede local onde a velocidade de placas de 100 a 1000 Mbps é suficiente

para o tráfego de comunicação processador-a-processador. Esta conexão é

suportada inclusive entre redes de maior distância com largura de banda

adequada, usando tecnologia como ATM ou Gigabit Ethernet. Na Figura 5 (TANENBAUM, 1995), pode-se ver um conjunto de

estações de trabalho ligada em rede que ilustram este sistema multicomputador

baseado em barramento.

Figura 5 Sistema

Constituído por Computadores Interligados em Rede

Outra forma de ligação de multicomputadores é a interligação por

comutação. Duas topologias são apresentadas por Tanenbaum (1995), sendo a

primeira chamada de topologia em grade, facilmente implementada em placas de

circuito impresso, e mostrada na Figura

6.

Figura 6 Topologia em Grade

A segunda topologia é chamada de hipercubo, onde os vértices representam

os processadores e os lados às interligações entre os processadores. Na Figura 7 (TANENBAUM, 1995), uma representação para este

esquema com dimensão 4 onde cada processador está ligado a outros 4

processadores.

Figura 7 Topologia em Hipercubo

Nesta forma de hipercubo à medida que se aumenta o número de

processadores maior fica o caminho para os processadores se comunicarem entre

si, pois a interligação não é direta e sim via os processadores que são

vizinhos na interligação.

Segundo Buyya (1999), “cluster é um tipo de sistema de processamento

distribuído ou paralelo, o qual consiste de um conjunto de computadores

interligados trabalhando juntos como se fosse um único recurso de computação

integrada”. Um nó pode ser um computador multiprocessado ou monoprocessado (PC,

estação de trabalho ou SMP) com memória, facilidade de I/O e sistema

operacional. Um cluster geralmente se refere a dois ou mais computadores

(nós) conectados entre si. Os nós podem estar em um único gabinete ou

interligados via LAN. A Figura

8 mostra uma arquitetura típica de um cluster (BUYYA,

1999).

Figura 8 Arquitetura Típica de um Cluster

Cluster oferece as seguintes facilidades a um custo relativamente

baixo:

·

Alta

performance

·

Escalabilidade

e facilidade de expansão

·

Alta performance

de processamento

·

Alta

disponibilidade

A tecnologia de cluster permite aumentar o poder de processamento,

usando tecnologia comum a preços

relativamente baixos. Isto devido ao uso de hardware e software, que são

padrões de mercado e com preços muito abaixo dos convencionais então

existentes. Um benefício muito importante quando se usa cluster é a

capacidade de suportar falhas, pois, se um nó do cluster deixa de

funcionar, o sistema como um todo ainda continua funcionando, apenas com uma

performance inferior devido ao nó que deixou de processar.

A interconexão entre os nós de um sistema em cluster pode ser

feita usando redes de alta velocidade com protocolo standard como TCP/IP ou

protocolos de baixo nível como Mensagens Ativas. O mais comum é que se use

placa de rede do tipo Ethernet. Em termos de performance, latência e largura de

banda, esta tecnologia está evoluindo. Uma conexão Ethernet simples não pode

ser usada como base para uma ligação cluster, pois a latência e a

largura de banda não estão de acordo com o poder computacional que temos nas

atuais estações de trabalho. Deve-se esperar que na interconexão de cluster

tenha-se largura de banda superior a 10 Mbytes/s e tempo de latência menor que

100 μs. Algumas das tecnologias de rede de alta performance, segundo Buyya

(1999), são apresentadas a seguir:

·

Ethernet, Fast Ethernet e Gigabit Ethernet

- A ethernet tem se tornado um padrão em redes de estações de trabalho.

Inicialmente tínhamos as placas de 10 Mbps,

seguidas pelas placas fast ethernet com velocidade 100 Mbps

usando hubs ou switch e atualmente, o estado da arte, é a placa gigabit ethernet que mantêm a

mesma simplicidade da arquitetura ethernet permitindo velocidades da

ordem de gigabit por segundo. Pode-se

também agregar múltiplas placas, formando um fluxo único com a

transmissão de diversas placas simultaneamente, chamado trunking, e

tem-se uma interconexão de alta velocidade entre as estações da rede.

·

Asynchronous Transfer Mode (ATM) - ATM é

uma tecnologia de circuito virtual chaveado, originalmente desenvolvida para a

indústria de telecomunicações. Baseado na transmissão de pequenos pacotes de

dados chamados células pode ser usado tanto em LAN como WAN. As placas com

tecnologia ATM têm um preço muito caro e não são largamente adotadas.

·

Scalable Coherente Interface (SCI) - O

objetivo do padrão SCI, ANSI/IEEE 1596-1992, é essencialmente prover um

mecanismo de alta performance que suporte o acesso à memória compartilhada

coerente, entre um grande número de máquinas. Esta transferência é feita com um

tempo de espera (delay) de poucos μss. Esta tecnologia não é

largamente empregada, seu custo é bastante alto e podemos encontrar em algumas

arquiteturas proprietárias de memória logicamente compartilhada e fisicamente

distribuída, tais como HP/Convex Exemplar SPP e Sequent NUMA-Q 2000 (DIETZ,

1998).

·

Myrinet - É uma solução proprietária da

empresa Myricom (2001), de alta performance para interconexão a 1.28 Gbps full

duplex. Myrinet usa switch roteadores cut-through de baixa

latência, oferecendo tolerância à falha pelo mapeamento automático da

configuração de rede. Tem baixo tempo de latência (5 μs sentido único,

ponto a ponto), excelente performance e grande flexibilidade devido ao

processador programável em sua placa.

Outras tecnologias de rede e formas de interligação de computadores tais

como, ArcNet, CAPERS, FC (fibre channel), FireWire (IEEE 1394), HiPPI e

serial HiPPI, IrDA (Infrared Data Association), Parastation, PLIP, SCSI,

ServNet, SHRIMP, SLIP, TTL_PAPERS, USB e WAPERS estão descritas em (DIETZ,

1998).

O software em Sistemas Distribuídos seja aplicativo ou mesmo

um sistema operacional, tem que estar de acordo com as características dos

Sistemas Distribuídos. Diferentemente de um sistema monoprocessado no ambiente

de Sistemas Distribuídos existem as necessidades de sincronismo, interação,

controles, entre os diferentes ambientes de software, ou diferentes instâncias,

que compõem o sistema total. Para o usuário final, tudo deve parecer como se

fosse um único recurso de computação que está sendo usado para o processamento

das necessidades do usuário. Neste contexto, vamos fazer a seguir, algumas

considerações sobre os sistemas operacionais e sobre a programação de aplicativos.

Segundo Buyya (1999), um sistema operacional moderno provê dois serviços

fundamentais para o usuário. Primeiro

ele permite utilizar o hardware de um computador mais facilmente criando uma

máquina virtual que difere da máquina real facilitando o uso da mesma por

usuários finais. Segundo, um sistema operacional compartilha recursos de

hardware entre os usuários. Um dos mais importantes recursos é o processador.

Um sistema operacional que trabalha com mais de um processo simultaneamente (multitask),

como o Unix ou WINDOWS NT, divide o trabalho que necessita ser executado pelo

processador, dando a cada processo memória, recursos do sistema e uma fração de

tempo do processador. O sistema operacional executa um processo (thread)

por um curto espaço de tempo e depois muda para outro, executando um a um

sucessivamente. Assim mesmo em um sistema com um único processador, temos a

impressão de múltiplas execuções simultâneas, pois cada processo está sendo

atendido pelo processador em pequenas frações de tempo. Um usuário pode editar

um documento, enquanto um relatório está sendo impresso e uma compilação está

sendo executada. Para o usuário tudo se parece como se os três programas

estivessem rodando simultaneamente.

De acordo com Tanenbaum (1995), pode-se distinguir dois tipos de sistemas

operacionais para sistemas com vários processadores: os sistemas operacionais

fracamente acoplados e os fortemente acoplados. Sistemas fracamente acoplados são aqueles onde temos as estações

independentes ligadas por rede local. Cada estação tem o seu sistema

operacional. Os nodos têm baixo grau de interação e interagem quando

necessário. Se a rede local cai, aplicações individuais em cada estação podem

continuar. Sistema fortemente acoplado é aquele onde o software integra,

fortemente cada nodo da rede. Se a interligação dos processadores for

interrompida, a aplicação também será descontinuada. Segundo os conceitos já

apresentados tem-se:

·

Sistemas Operacionais de Rede – Software

fracamente acoplado em hardware fracamente acoplado.

·

Sistemas Operacionais Distribuídos – Software

fortemente acoplado em hardware fracamente acoplado.

·

Sistemas Operacionais de Multiprocessadores –

Software fortemente acoplado em hardware fortemente acoplado.

Sistemas Operacionais (SO) de Rede

permitem compartilhar diferentes recursos de uma determinada estação

entre os demais membros da rede. Um dos recursos mais importantes para ser

compartilhado é o disco, permitindo que múltiplas estações possam acessar uma

única base de dados. Diversos produtos comerciais estão disponíveis, entre eles

Rede Novell da Novell, Inc, WINDOWS NT da Microsoft e NFS (Network File

System) da SUN Microsystems. O NFS se tornou um padrão de mercado e hoje

todos os UNIX têm uma implementação de NFS. Permite que uma determinada área de

disco, um diretório ou conjunto de diretórios, seja exportado para outras

máquinas da rede. No servidor existe um arquivo de configuração onde se dá

permissão de acesso explicitando qual área e que modo de acesso cada máquina

cliente vai estar autorizada nesta interligação. Na máquina cliente se monta um

determinado diretório da máquina servidora sob o sistema de arquivos local e a

área compartilhada para ser vista como se fosse parte da estrutura de arquivos

do sistema local. Qualquer máquina com S.O. Unix pode ser cliente e/ou

servidora de um sistema NFS e a Figura

9 (TANENBAUM, 1995), mostra a estrutura em camadas dos

componentes envolvidos em uma ligação Cliente / Servidor.

Figura 9 Estrutura em Camadas do NFS

Sistemas verdadeiramente

distribuído, vão além do simples uso do NFS.

“Um sistema distribuído é aquele que roda em um conjunto de máquinas sem

memória compartilhada, máquinas estas que mesmo assim aparecem como um único

computador para seus usuários” (TANENBAUM, 1995). Deve haver um sistema de

comunicação entre processo, único e global

que permita que qualquer processo fale com qualquer outro. Também deve

haver um esquema de proteção

global. A gerência dos processos também

precisa ser a mesma em todo o sistema. A forma como um processo é criado,

destruído, inicializado e finalizado, não pode variar de uma máquina para

outra.

Sistemas Multiprocessadores de tempo compartilhado, combinação de

software fortemente acoplado com hardware fortemente acoplado, são voltados

para processamentos específicos. A

característica fundamental desta classe de sistema é a existência de uma única

fila de processos prontos: uma lista de todos os processos do sistema que não

estão bloqueados, e que só não estão rodando por falta de processador

disponível. O sistema da Figura

10 (TANENBAUM, 1995) mostra uma situação com três

processadores e cinco processos prontos para rodar.

Figura 10 Um Multiprocessador com uma Única Fila de

Processos Prontos

Segundo Stallings (1998), um sistema operacional de redes não é

atualmente um sistema operacional, mas sim um conjunto distribuído de softwares

de sistema para suportar o uso de servidores em uma rede. A máquina servidora

provê serviços para a rede como gerenciamento de impressora e compartilhamento

de arquivos. Cada computador da rede tem seu próprio sistema operacional. O

sistema operacional de redes é simplesmente um complemento ao sistema

operacional local que permite a interação entre as máquinas de aplicação com a

máquina servidora. Já um sistema operacional distribuído é um sistema

compartilhado por uma rede de computadores. Aparece para o usuário final como

se fosse um único sistema operacional, mas fornece acesso transparente a

recursos de diversas máquinas. Um sistema operacional distribuído pode

aproveitar uma arquitetura de comunicação já existente, no entanto mais

comumente um conjunto de instruções básicas para funções de comunicações é

incorporado ao sistema operacional de forma a prover mais eficiência.

A implementação do sistema uniprocessador virtual só é possível se

tivermos memória compartilhada para serem acessadas pelos multiprocessadores.

Esta solução para redes de computadores fica muito difícil, senão impossível,

devido à baixa velocidade e alta latência no processo de intercomunicação entre

os processadores.

Do ponto de vista da aplicação, a forma como os programas podem ser

desenvolvidos bem como o uso dos recursos existentes, estão relacionados com a

arquitetura de processamento paralelo ou processamento distribuído. Segundo

Radajewski (1998), tem-se basicamente duas formas de comunicação entre os

processos durante a sua fase de execução:

1. Usando

threads (linhas de execução, parte do código que roda independente),

recurso do sistema operacional, em máquinas de memória compartilhada, onde as

comunicações são feitas através da memória diretamente, em máquinas do tipo SMP;

2. Via

mensagens, em máquinas onde o acesso à memória é feito através de mensagens que

são trocadas entre os processos de cada máquina, exemplo Cluster ou

interligadas em rede.

Tanto mensagens quanto threads podem ser implementadas em SMP,

NUMA-SMP e cluster embora eficiência e portabilidade em cada caso, tenham as

seguintes considerações:

·

Mensagens - historicamente a tecnologia de troca

de mensagens refletia o projeto dos primeiros computadores paralelos com

memória local. Mensagens requerem que os dados sejam copiados enquanto threads

usam os dados no mesmo local. A latência e a velocidade com que as mensagens

podem ser copiadas são os fatores limites neste modelo de troca de mensagens.

Uma mensagem é bastante simples: alguns dados e um processador de destino.

Alguns mecanismos comuns são interfaces de programas de aplicação tais como PVM

(Parallel Virtual Machine) ou MPI (Message Passing Interface). O

mecanismo de troca de mensagens pode ser eficientemente implementado usando threads

e terá bom resultado tanto em máquinas SMP como entre clusters e máquinas em

rede.

·

Threads - as threads em sistema

operacional foram desenvolvidas devido ao projeto de compartilhamento de

memória o que permitiu uma comunicação em memória muito rápida e sincronização

entre as partes de programas concorrentes. As threads funcionam bem em

sistemas SMP por que a comunicação é feita através da memória compartilhada. O

problema com threads é a dificuldade de estender o uso além de máquinas

SMP pois sendo os dados compartilhados entre CPUs o overhead para atualizar o

cache de memória, coerência de cache, seria muito grande. Para estender threads

eficientemente além dos limites do SMP, seria necessário usar a tecnologia NUMA

o que é muito caro.

A programação paralela ou programação distribuída terá realmente vantagem

com esta arquitetura de sistemas paralelos e sistemas distribuídos se a

aplicação for adequada para este ambiente. Inicialmente considera-se a

diferença entre concorrência e paralelismo. Partes concorrentes são partes de um programa que podem ser executados

independentemente. O paralelismo é quando temos partes concorrentes deste

programa que podem ser executadas ao mesmo tempo em elementos de processamento

separados. A distinção é muito importante pois concorrência é uma propriedade

do programa e um eficiente paralelismo é uma propriedade do equipamento. A

tarefa do programador é identificar que parte concorrente pode ser executada em

paralelo e qual parte não pode.

O

Ambiente de Computação Distribuída, (DCE – Distributed Computing Environment)

é uma tecnologia de software desenvolvida pelo Open Group (OPEN, 1999), que

permite o desenvolvimento de aplicações distribuídas usando sistemas

heterogêneos. O Open Group é um consórcio de usuários e de fornecedores de

computadores que trabalham em conjunto visando à tecnologia de sistemas

abertos. A organização integra as melhores tecnologias e fornece para que sejam

adotadas pelas industrias. Através do Open Group, diversos segmentos da

empresas trabalham de forma cooperativa para a evolução do DCE. Algumas áreas

críticas que são atendidas por esta tecnologia:

·

Segurança

·

Internet / Intranet

·

Objetos Distribuídos

A tecnologia DCE foi projetada para trabalhar independente de qual sistema

operacional ou qual tecnologia de rede está sendo usada pela aplicação. Assim

permite uma interação entre clientes e servidores em qualquer tipo de ambiente,

mesmo heterogêneo, que a organização possa ter.

O

Open Group fornece o código fonte do DCE os quais os fornecedores incorporam a

seus produtos. Muitos fornecedores já agregam funções básicas do DCE junto com

os seus sistemas operacionais. A tecnologia inclui serviços de software que

residem acima do sistema operacional, fornecendo interface (middleware)

para os recursos de baixo nível do sistema operacional e recursos de rede.

Estes serviços permitem que a organização possa distribuir o processamento e os

dados através de toda a empresa. Atualmente DCE é o único ambiente integrado de

serviços, não vinculado a um fornecedor específico, que permitem as

organizações desenvolverem, usarem e manterem aplicações distribuídas através

de redes heterogêneas.

Os

serviços DCE incluem:

·

RPC – Chamada de procedimento remoto, o que facilita a

comunicação cliente-servidor, e então uma aplicação pode efetivamente acessar

recursos distribuídos através da rede.

·

Serviço de Segurança – Autentica a identidade dos

usuários, autoriza o acesso a recursos em redes distribuídas e provê a

contabilização de usuários e servidores.

·

Serviço de Diretórios – Provê um modelo único de nome

através do ambiente distribuído.

·

Serviço de Relógio – Sincroniza os relógios dos

sistemas através da rede.

·

Serviços de Threads – Provê a capacidade de

execução de múltiplas threads.

·

Serviço de Arquivos Distribuídos – Provê acesso a

arquivos através da rede.

Com

relação à segurança, DCE é um dos mais seguros ambientes de computação

distribuída. Incorpora a tecnologia Kerberos, uma forma, altamente confiável,

bem gerenciada e bem entendida de proteger computação em rede.

Interagindo

com a tecnologia hoje existente para internet/intranet a tecnologia para

servidores seguros WEB prevê uma integração com os serviços de nome e serviços

de segurança do DCE. Assim uma

integração do DCE com Secure-http complementando as facilidades de segurança já

existentes com autenticação de usuários para acesso a serviços WEB de

informações restritas.

Com

relação à tecnologia de objetos distribuídos, DCE lidera a interoperabilidade

de diferentes estratégias para objetos distribuídos. DCE permite o uso de objetos distribuídos sem desconsiderar

propostas como CORBA. De fato DCE tem os pré-requisitos das especificações

CORBA como um ambiente específico Inter Orb Protocol que já está disponível,

testado e em uso atualmente. DCE é um componente chave para muitos vendedores

implementarem tecnologias de orientação a objetos. Como exemplo a IBM tem

acordo para suportar os serviços de segurança, nome e relógio do DCE em seu

SOM/DSOM. Hewlett-Packard esta fornecendo DCE++, uma ferramenta orientada a

objeto que provê um compilador C++IDL e biblioteca de classes para DCE. A

Microsoft usa DCE como base para a comunicação com ActiveX. Digital usa a

segurança do DCE em seu ObjectBroker, seu CORBA. Muitos fornecedores têm

expressado a sua intenção em usar DCE RPC como um protocolo específico dentro

da especificação CORBA para prover interoperabilidade.

A programação orientada a objeto é considerada atualmente um dos melhores

modelos de programação para tratar com sistemas complexos enquanto provê

facilidade de manutenção, novas implementações e reusabilidade. Um modelo

contendo estes atributos é particularmente interessante para sistemas

distribuídos, já que estes tendem a se tornar muito complexos. A base da

programação orientada a objeto é o conceito de objeto, que é uma entidade que

encapsula um estado e permite o acesso através de uma interface bem definida.

Programação distribuída orientada a objeto generaliza a programação

orientada a objeto para sistemas distribuídos, estendendo o modelo de objeto

com interação remota cliente/servidor entre objetos não locais. No modelo

cliente/servidor, o servidor provê acesso aos clientes para serviços

específicos através de mecanismos de intercomunicação de processos, IPC, tais

como passagem de mensagens ou chamadas de procedimentos remotos. Na programação

distribuída orientada a objeto um servidor de objetos encapsula um estado

interno e prove o serviço para uma coleção de objetos clientes remotos. Assim

como na pura programação orientada a objeto, este serviço é abstraído através

da interface, ou seja, uma coleção de métodos que podem ser usadas para acessar

o serviço. Clientes que estão residindo em diferentes máquinas podem invocar

estes métodos através da invocação de métodos remotos.

Nos últimos anos tem surgido diversos ambientes de desenvolvimento

baseados no paradigma da programação distribuída orientada a objeto. Estes

ambientes, entre eles os mais notáveis exemplos são CORBA (OMG, 1998), JAVA

Remote Method Invocation (RMI) (SUN, 1998), e DCOM (Distributed

Component Objet Model) (GALLI,1998).

A seguir discutem-se as principais características destes sistemas.

2.4.4.1 CORBA - Common Object Request Broker Architecture

Existe um consórcio internacional de indústrias que promove a teoria e a

prática de programação distribuída orientada a objetos que é chamado de OMG – Object

Management Group (OMG, 1998). Seu objetivo é definir uma arquitetura padrão

e comum para que através de diferentes plataformas de hardware e sistema

operacionais, possa ser feita a intercomunicação entre objetos. O consórcio OMG

foi fundado em 1989 por oito companhias e atualmente conta com cerca de 800

membros, com a participação dos maiores fabricantes de computadores. Esta

organização não desenvolve projetos, trabalha com as tecnologias existentes

oferecidas pelas empresas membros do consorcio.

Figura 11 Modelo de Referencia OMG OMA

Sua forma de trabalho é divulgar RFPs – Request for Proposals em

todos os aspectos da tecnologia de objetos solicitando especificações de novos

componentes. Membros podem então propor uma especificação que é acompanhada

pela implementação provendo o detalhamento dos conceitos inerentes a esta especificação.

Um processo de revisão e votação é conduzido e assim que a especificação é

aceita, qualquer fabricante pode implementar esta alternativa em seu produto

para o mercado.

O consorcio OMG tem desenvolvido um modelo conceitual, conhecido como core

object model, e uma arquitetura de referencia, chamada OMA – Object

Management Architecture sobre a qual as aplicações podem ser construídas. A

OMG OMA se propõem a definir em alto nível de abstração, as muitas facilidades

necessárias para a computação distribuída orienta a objetos. Assim é proposto

um modelo de referencia OMA com cinco

partes principais, representados na Figura

11 (OMG,1998), como segue:

·

ORB – Object Request Broker, (também

comercialmente conhecido como CORBA)

que é um barramento comum de comunicação para os objetos. Permite que

objetos clientes de forma transparente e confiável, requisitem operações em

objetos remotos e recebam respostas em um ambiente distribuído. A integração de

objetos distribuídos está disponível através de plataformas, independente de

sistemas operacionais e serviços de transporte da rede.

·

Serviço de Objetos – são componentes de uso geral

fundamentais para o desenvolvimento de aplicações CORBA. Um serviço de objetos

é basicamente um conjunto de objetos CORBA que podem ser requisitados através

do ORB. Serviços não estão relacionados com nenhuma aplicação especifica mas

são blocos de construção básica, usualmente provida no ambiente CORBA,

suportando funcionalidades básicas úteis para muitas aplicações. Diversos

serviços, tem sido projetados e adotados como standard pela OMG (OMG, 1998), incluindo notificação de

eventos, interfaces de processamento de transação, segurança, controle de

autenticação, etc.

·

Interfaces de Domínio – representam áreas verticais que

provêem funcionalidades de interesse direto para usuários finais em específicos

domínios de aplicação tais como financeiro ou saúde.

·

Facilidades Comuns – provêem ao usuário final funções

úteis em diversas aplicações que podem ser configuradas para uso específico em

aplicações particulares. São facilidades relacionadas com o usuário final, tais

como serviço de impressão, gerenciamentode documentos, e correio eletrônico.

·

Interface de Aplicação – são específicas para

aplicações de usuário final. Representam aplicações baseadas em componentes,

executando tarefas especificas para o usuário. Uma aplicação é tipicamente

composta de um grande número de

objetos, alguns dos quais são específicos da aplicação e outros parte

dos serviços de objetos, facilidades comuns ou interface de domínios.

Todos os serviços OMG devem ser especificados usando OMG – IDL (Interface

Definition Language). Uma linguagem puramente declarativa e não provê

detalhes da implementação. É uma linguagem de programação neutra, independente

de rede e assim usada como uma forma de descrever os tipos de dados. A sintaxe

do OMG IDL é derivada do C++, removendo

os construtores de uma linguagem de implementação e adicionando um número de

novas palavras chaves necessárias para a especificação de sistemas

distribuídos.

Uma definição de CORBA (COULOURIS, 2001), “é um middleware que

permite aos programas de aplicação se comunicarem entre si, independente de

suas linguagens de programação, sua plataforma de hardware e de software e a

rede sobre a qual eles se comunicam”. As aplicações são construídas com objetos

CORBA os quais implementam interfaces definidas na linguagem de definição de

interfaces (IDL). Clientes acessam os métodos nos IDL interfaces dos objetos

CORBA por meio de invocação método remota (RMI). O componente de middleware

que suporta RMI é chamado de distribuidor de requisição de objetos (ORB – Object

Request Broker). A especificação do CORBA foi patrocinada por membros do

grupo OMG – Object Management Group. Muitos diferentes ORBs foram

implementados segundo a especificação, suportando uma variedade de linguagens

de programação. Os serviços CORBA provêem facilidades genéricas que podem ser

usadas em uma grande variedade de aplicações.

JAVA Remote Method Invocation (RMI) é um modelo de objeto

distribuído para a linguagem JAVA que mantém a semântica do modelo de objeto

JAVA, tornando a distribuição de objetos fácil de implementar e de usar

(EMMERICH, 1999). Na terminologia standard

JAVA RMI, um objeto remoto é um cujos métodos podem ser chamados de outra

máquina virtual JAVA. Um objeto deste tipo é descrito por um ou mais interfaces

remotas, que são interfaces JAVA que declaram qual método do objeto remoto pode

ser chamado remotamente. RMI refere-se a ação de invocar um método de uma

interface remota em um objeto remoto.

Figura 12 Arquitetura JAVA RMI

A arquitetura JAVA RMI é ilustrada na Figura

12. Usa o mecanismo padrão (derivado de RPC) para

comunicação com objetos remotos: stubs e skeletons. Um stub

para um objeto remoto atua como um cliente local, representativo para o objeto

remoto. Clientes nunca interagem diretamente com objetos remotos, mas somente com objetos stub os quais são

responsáveis por fazer a chamada em seu remoto objeto destino. Um skeleton

para um objeto remoto é uma entidade no lado do servidor que contém o método

que dispara a chamada para a implementação do atual objeto remoto. Stubs

e skeleton são gerados pelo compilador

RMIC fornecido com a distribuição padrão do JAVA RMI.

Um stub para um objeto remoto implementa o mesmo conjunto de

interfaces remotas implementado pelo objeto remoto. Quando um método do stub

é chamado, ele faz o seguinte:

·

Inicia a conexão com a máquina virtual JAVA remota que

contém o objeto remoto.

·

Escreve e transmite os parâmetros para a máquina

virtual JAVA.

·

Espera pelo resultado destas chamadas.

·

Lê o valor de retorno ou exceção retornada.

·

Retorna o valor a quem chamou.

Na máquina virtual JAVA, cada objeto remoto pode ter um skeleton

correspondente.(na versão JDK 1.2 skeletons não são obrigatórios) O skeleton

é responsável por disparar a chamada para a atual implementação do objeto

remoto. Quando o skeleton recebe uma chamada faz o seguinte:

·

Lê os parâmetros para o método remoto

·

Chama o método na implementação do atual objeto remoto.

·

Transmite o resultado para quem chamou.

A implementação da camada de seção no JAVA RMI suporta a ativação de

objetos sob demanda através da interface de ativação. Assim evita que no JAVA

RMI objetos servidores estejam em memória todo o tempo permitindo que sejam

carregados dinamicamente, quando necessário. A ativação é completamente

transparente e está representada na Figura 13 (EMMERICH, 1999).

Figura 13

Ativação de Objetos Remotos em JAVA RMI

O modelo de objetos componentes distribuídos (Distributed Component

Objet Model – DCOM) é o padrão adotado pela Microsoft para distribuição de

objetos (GALLI, 1998). Estabelece um modelo de programação, padrão binário, bem

como um padrão de interoperabilidade para a computação usando objetos

distribuídos. DCOM está disponível desde o WINDOWS NT 4.0 e tinha versões que poderiam ser obtidas na

internet para o WINDOWS 95. Está incluído no Microsoft Internet Explorer 4.0,

no WINDOWS 98 e disponível para diversas plataformas UNIX fornecido por uma

empresa chamada Software AG. Embora iniciado pela Microsoft, COM e DCOM não é

mais ambiente proprietário da Microsoft. Atualmente o consorcio independente

ActiveX é responsável pelo gerenciamento deste padrão.

O modelo básico COM inclui a habilidade de permitir que elementos lógicos

sejam considerados independentes. Também permite componentes binários flexíveis

para adaptação a diferentes configurações e máquinas. COM é mais largamente

conhecido como a tecnologia básica do ActiveX.

Qualquer ferramenta de software que suporta componentes COM, automaticamente suporta DCOM. Existem quatro

serviços no ambiente do servidor ActiveX que são particularmente úteis para

DCOM: transações, incluindo a capacidade de recuperação e volta ao estado

original; enfileiramento com filas confiáveis de armazenamento e envio que

permitem operações em redes sujeitas a intermitentes falta de acesso; uso de script no servidor para permitir

fácil integração com aplicações de internet baseadas em HTML; e acesso a

sistemas de produção legados. DCOM

permite que a tecnologia COM possa se comunicar diretamente através de redes.

Alguns pontos importantes do DCOM são:

·

Independência de transporte – DCOM permite que os

componentes se comuniquem, seja com ou sem orientação a conexão. Suporta TCP/IP, UDP/IP, IPX/SPX,

Apple Talk e HTTP.

·

Tecnologia aberta – DCOM é uma tecnologia aberta e está

disponível para UNIX, Apple, WINDOWS e alguns ambientes mais antigos. Contudo é

mais comum no ambiente WINDOWS.

·

Integrado com servidor e browser WEB – Como DCOM

inclui ActiveX e os componentes ActiveX podem ser incluídos em aplicações

baseadas em browser DCOM permite distribuir aplicações internet que

suportam tecnologias de browser.

·

Segurança – DCOM pode integrar segurança na internet

baseada em certificados.

·

Extensão do mecanismo RPC do Ambiente de computação

distribuída (DCE) – DCOM usa e estende este mecanismo de RPC do DCE.

A

arquitetura básica DCOM permite que uma aplicação possa ser desenvolvida de

maneira que automaticamente permita uma distribuição futura e com

escalabilidade. Assim se uma demanda maior de uma aplicação acontece podemos

aumentar a capacidade do servidor para atender esta necessidade. Entretanto se

instalarmos um novo servidor e a aplicação estiver no padrão DCOM poderemos

distribuir a execução sendo que parte da aplicação poderá rodar no servidor antigo e parte no novo

servidor. Para se comunicar com um

componente que não seja local, DCOM emprega um mecanismo de comunicação inter

processos que é completamente transparente para a aplicação. Especificamente

DCOM substitui o mecanismo de comunicação local por um protocolo de comunicação

em rede. Desta forma DCOM permite independência e transparência de local para a

aplicação.

Os nomes de instância em DCOM são referenciados como monikers. São

por si só objetos e permitem extrema flexibilidade. Identificadores que vão

desde um nome de banco de dados, um servidor, até um endereço URL ou uma pagina

HTML podem ser caracterizados como uma instância de um objeto. Monikers

contém as informações necessárias e lógicas para localizar uma corrente instância

que está sendo executada do objeto que ele está se referindo. As instâncias que

estão sendo executadas, são listadas na tabela ROT – Running Object Table.

Esta tabela é usada pelo Monikers para encontrar instâncias de objetos

que estão em execução, rapidamente.

Monikers armazenam informações de referencia sobre o estado de um

objeto. Estas informações estão tipicamente armazenadas em um banco de dados.

Um objeto pode indicar para o moniker qual é a atividade quando o estado do

objeto for armazenado. Assim uma operação de acesso a dados pode prevenir um

possível gargalo se o objeto rodar no mesmo servidor onde estão os dados. Se

múltiplos clientes necessitam acessar o objeto, o objeto precisa executar em um

lugar acessível a todos os clientes.

DCOM executa uma chamada a método remoto quando um cliente quer chamar um

objeto em outro espaço de endereçamento.

No DCOM a linguagem de descrição de interface (IDL) foi construída em

cima do padrão DCE RPC. Como é usual em RPC todas as informações parâmetros são

disponibilizadas após serem concatenadas em um único espaço de memória, sendo

passado o endereço desta área. O cliente faz o processo inverso e a partir do

endereço, recria os dados que o processo vai receber. O retorno desta chamada

volta com parâmetros segundo o mesmo processo anterior. O lado do cliente é

conhecido como proxy e o lado do servidor e conhecido como stub. Um tipo adiciona de dados não incluído em

DCE RPC é o ponteiro de interface. Estes tipos de ponteiros podem aparecer como

resultado da CoCreateInstance ou como parâmetro para a chamada de um método.

Para tratar este novo tipo de dado a criação de um par proxy/stub é feita com a capacidade de tratar este

novo tipo de dados em todos os métodos da interface.

O mecanismo primário para controle do tempo de vida de um determinado

objeto é um contador de referencia.

Este contador incrementa quando se usa AddRef e decrementa com o Release. Como

nem todos os clientes terminam normalmente,

um processo de Ping é empregado. Cada objeto exportado tem um tempo de

PingPeriod e um contador de numPingsToTimeOut. A combinação destes valores

determina o tempo total conhecido como período de ping. Se este tempo passa sem

que ocorra um ping para o referido objeto, a referencia remota é

considerada expirada. O contador de referencia é decrementado como se o

processo tivesse terminado normalmente. Quando um objeto não tem referencia

ativa, um processo de coletor de lixo se encarrega de liberar a memória então

ocupada por este objeto.

COM e DCOM operam com a capacidade de multithread nativa do

sistema operacional. Assim a comunicação inter processo no DCOM requer DCE RPC,

que por sua vez requer que mensagens RPC sejam processadas em uma thread

arbitrária. DCOM provê sincronização automática do método de chamada para uma thread

simples. DCOM usa o modelo apartamento com relação ao tratamento de threads.

Com relação aos parâmetros podemos pensar em cada thread como um

processo separado. Acesso na mesma thread é acesso direto enquanto de

diferentes thread é indireto, possivelmente através do proxy/stub. Um

objeto pode suportar qualquer dos modelos de thread que segue:

·

Apartamento Thread única, thread principal

somente – Neste modelo todas as instâncias são criadas na mesma thread

única associada com este objeto.

·

Apartamento Thread única – Neste modelo uma

instância é amarrada a uma thread única contudo diferentes instâncias

podem ser criadas em diferentes threads.

·

Apartamento Multithread – Neste modelo

instâncias podem ser criadas em múltiplas threads e podem ser chamadas

em threads arbitrarias.

Qualquer

objeto implementa como o servidor local controla o tipo de apartamento usado

para seu objeto. Quando um objeto está

sendo criado, COM necessita saber se o objeto é compatível com o modelo de thread

do objeto pai. Se o objeto filho não é compatível, COM tenta carregar o objeto

em um apartamento diferente que seja compatível.

Assim como qualquer sistema que suporta computação distribuída DCOM

também tem seus aspectos de segurança:

·

Segurança de acesso – Assegura que um objeto

possa ser chamado somente por objetos que tenham a permissão apropriada.

·

Segurança no lançamento – Assegura que somente

objetos apropriados possam criar novos objetos em um novo processo.

·

Identidade – O principio de como um objeto

identifica a si mesmo.

·

Políticas de conexão – Se uma mensagem pode ser alterada e se uma mensagem é capas

de ser interceptada por outro objeto.

Segundo Emmerich (1999), quando avalia-se CORBA, JAVA e DCOM encontramos

os seguintes pontos chaves:

·

CORBA, DCOM e JAVA/RMI permitem que objetos clientes

requisitem a execução de operações de objetos servidores distribuídos. Estas

operações são parametrizadas e detalhados mecanismos de passagem de parâmetros

são especificados.

·

CORBA, DCOM e JAVA/RMI todos usam uma forma de

referência para identificar objetos servidores de forma transparente quanto à

localização. Objetos CORBA são identificados por referencia ao objeto, objetos

COM são identificados por ponteiros de interface e objetos JAVA/RMI são

identificados por referencias de falta.

·

JAVA/RMI é diferente de CORBA e DCOM pelo fato que

integra objetos não remotos ao modelo objeto. Isto é obtido modificando o

mecanismo padrão de passagem de parâmetros no modelo e passando objetos não

remotos por valor.

·

O modelo objeto do CORBA, DCOM e JAVA/RMI, todos

separam a noção de interface e implementação. A separação é mais específica em

CORBA e DCOM, onde existem linguagens separadas para definir interfaces e onde

a implementação pode ser escrita em diferentes linguagens de programação.

·

Os modelos de objetos dos três ambientes suportam

herança. Todos especificam uma classe primária que é usada para derivar

propriedades comuns a qualquer objeto referenciado. Esta classe principal é

Object para CORBA, IUnknown im DCOM e Remote in JAVA/RMI.

·

Nos três enfoques, atributos são tratados como

operações. Pode ser implícito como em CORBA ou explicitamente incorporado pelo

projetista usando DCOM ou JAVA/RMI.

·

Todos os modelos de objeto têm suporte para tratar com

falhas durante a requisição de objetos.

·

Todos os modelos de objeto são estaticamente de um tipo

(tipo de variável) e suportam uma forma restrita de polimorfismo. Em todos os

modelos é possível associar um objeto a uma variável de diferente tipo desde

que o tipo da variável estática seja um supertipo do tipo do objeto dinâmico.

·

Em todos os três sistemas de middleware tem-se

geradores para os clientes e stubs no servidor para implementar a camada

de apresentação. CORBA usa stubs no cliente e implementa skeletons. DCOM usa interface proxie

e interface stub. Em JAVA/RMI eles são referenciados como stubs e

skeletons.

·

CORBA, COM e JAVA/RMI todos suportam a ativação sob

demanda de objetos servidores. CORBA

tem esta facilidade através de adaptador de objeto; em DCOM é

implementado pelo gerenciador de controle de serviço; em JAVA/RMI o ativador

implementa esta ativação.

A comunicação em sistemas distribuídos se torna mais complexa, pois a

troca de informações entre dois processos localizados em máquinas distintas

depende primeiramente da interligação destas máquinas. Quando em um único

equipamento dois processos podem se comunicar através da memória compartilhada

que é comum e acessível aos dois processos simultaneamente. Segundo Stallings

(1998), a interligação dos equipamentos hoje pode ter vários enfoques desde o

tratamento de um computador pessoal como um simples terminal até um alto grau

de integração entre aplicações em computadores pessoais e servidores de banco

de dados.

Uma das arquiteturas que se tornou padrão de mercado é o TCP/IP (Transmission

Control Protocol/Internet Protocol), amplamente usado nos dias atuais e que

será visto com mais detalhes na seqüência.

Segundo Stallings (1998), TCP/IP é o resultado de um protocolo pesquisado

e desenvolvido na rede experimental ARPANET, fundada pela DARPA (Defense

Advanced Research Projects Agency) e genericamente conhecido como conjunto

de protocolos TCP/IP. Este conjunto de protocolos foi transformado em padrões

internet pelo IAB (Internet Architecture Board). Não há um modelo oficial de protocolo TCP/IP

como no caso do modelo OSI. Contudo, baseados nos protocolos padrões que foram

desenvolvidos nos podemos organizar as tarefas de comunicação para o TCP/IP em

cinco níveis independentes:

·

Camada de Aplicação – contém a lógica necessária

para suportar as várias aplicações de usuários. Para cada tipo diferente de

aplicação, como exemplo a transferência de arquivos, um módulo separado é

necessário para esta aplicação peculiar.

·

Camada de transporte – Independente da natureza

da aplicação, os dados que estão sendo trocados entre as aplicações precisam

ser confiáveis. O controle da ordenação dos pacotes para garantir que sejam

recebidos na mesma ordem que são transmitidos é uma tarefa que independe da

natureza da aplicação. O protocolo de controle de transmissão (TCP) é o mais

comum nesta camada.

·